La Cnil publie ses recommandations sur l'usage de l'IA dans les services publics

La Cnil a publié le bilan de trois expérimentations de l'intelligence artificielle dans les services publics. Avec à la clé des recommandations qui intéresseront toutes les collectivités souhaitant déployer de l'IA générative, des algorithmes prédictifs ou des caméras Lidar manipulant des données personnelles.

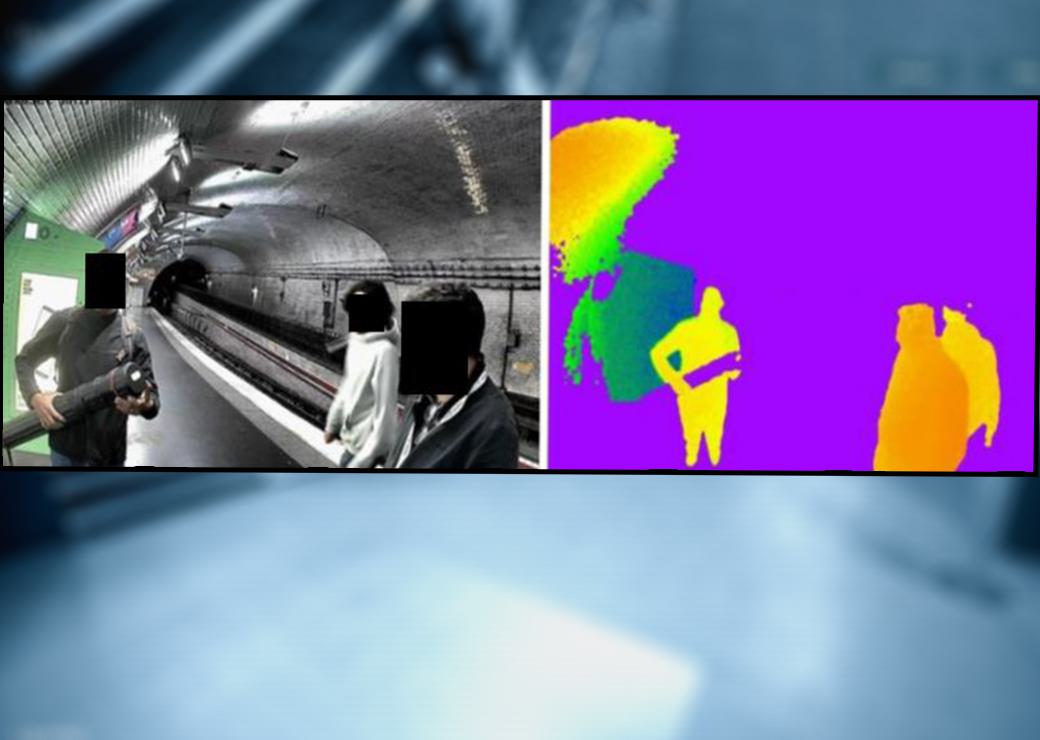

© RATP, visuel figurant p. 13 de la note de la Cnil et Adobe stock/ Comparaison d'images de la même scène issues d'une caméra classique (à gauche) et d'un capteur temps de vol (à droite)

La Cnil a publié le bilan de son accompagnement de trois projets d'IA dans les services publics. Avec cette approche "bac à sable ", la commission s'appuie sur le terrain pour formuler des recommandations opérationnelles aux porteurs de projets d'IA. Cet accompagnement s'est déroulé entre janvier et juillet 2024 et a concerné trois administrations. France Travail tout d'abord, accompagné sur un outil de recommandation de formations basé sur l'IA générative à destination de ses conseillers. Nantes Métropole ensuite, coachée sur le projet "Ekonom'IA", un système d'IA visant à sensibiliser les abonnés à l'eau potable sur leur niveau de consommation en le comparant à celui de foyers similaires. Enfin, la RATP a sollicité l'appui de la Cnil pour son projet "Priv-IA", un système de capteurs Lidar alternatifs aux caméras de vidéoprotection classiques.

Implication nécessaire des agents

Pour le projet d'IA générative de France Travail, la Cnil insiste sur la place de l'humain. La Cnil recommande d'assurer une intervention humaine "significative" pour éviter les décisions individuelles automatisées. Des agents qui doivent comprendre le fonctionnement de l'outil mis à leur disposition, ce qui suppose qu'ils soient formés et que les systèmes d'IA soient documentés. Plus globalement, il s'agit de "créer des conditions de travail adéquates permettant d'exercer un véritable pouvoir de jugement", ce qui induit que les agents puissent refuser de suivre les suggestions d'une IA qu'ils estimeraient non pertinente.

La Cnil insiste également sur le principe de minimisation des données utilisées par les IA génératives lorsque l'utilisateur renseigne les invites (prompt). Aussi recommande-t-elle d'harmoniser et standardiser les prompts dès lors qu'ils concernent des usagers. Elle suggère aussi de mettre en place des filtres de protection (avec des mots interdits) ou des alertes pour éviter l'usage de données sensibles dans les interactions avec l'IA.

Identification difficile des biais

Autre enjeu : faire en sorte que l'IA ne sorte pas systématiquement les mêmes propositions. Dans le cas de France Travail, par exemple il y a le risque que l'IA "invisibilise" certaines offres de formation. Pour l'éviter, elle recommande d'harmoniser les bases de données requêtées par l'IA. Plus largement, la Cnil met en garde sur les risques de biais dans les réponses de ces chatbots.

Dans le cas de France travail, la localisation des demandeurs d'emploi, leur genre, leurs patronymes voire leur parcours personnel pourraient conduire à ne leur proposer que certaines formations. Mais si les administrations sont incitées à repérer les sources potentielles de biais et à apporter des garanties proportionnelles aux usagers, l'éradication des biais n'est pas aisée reconnait la Cnil. Le RGPD interdit en effet de traiter des données sensibles, même pour tester les biais d'un système d'IA… En attendant des avancées sur ce point – l'IA act promet de faire bouger les lignes – France travail peut conserver les invites à des fins d'audit. Une conservation à "mettre en balance avec les mesures de minimisation et de protection des données d'entrée" relève la Cnil.

Anonymisation sur mesure

Concernant le projet nantais Ekonomia, on notera que si la finalité du projet a été validée comme relevant bien de l'intérêt public (économiser l'eau), le projet s'est heurté à un problème d'accès aux données, notamment fiscales. Face à la difficulté de lever le secret fiscal, la collectivité a été contrainte d'utiliser des données fictives, ou synthétiques pour utiliser le vocabulaire de l'IA. Les tests d'anonymisation et de pseudonymisation sur ces données ont montré des "résultats satisfaisants" en conservant leurs propriétés statistiques. La Cnil pointe cependant des risques de réidentification du fait de profils particulier comme une famille nombreuse ou d'une consommation d'eau très élevée corrélable à un bâtiment spécifique. Pour les limiter, la Cnil incite à ajouter du "bruit" sur les valeurs extrêmes. Et dans tous les cas, la Cnil recommande d'adapter les méthodes d'anonymisation et de pseudonymisation à la spécificité de chaque projet. Autre recommandation : la nécessité de bien informer les usagers sur l'usage de leurs données et les finalités du projet en proposant une information compréhensible par tous, distincte du contrat d'approvisionnement en eau.

Pas de validation par principe des caméras Lidar

Le projet RATP visait pour sa part à évaluer l'intérêt d'une caméra "temps de vol" utilisant une technologie laser/infrarouge, du type Lidar, pour repérer des objets dans un espace, en tant qu'alternative aux caméras classiques. Dans ce cas, l'IA analyse les nuages de points pour en tirer des informations opérationnelles : compter des individus, détecter des mouvements ou leur absence, identifier un objet et le classifier… le tout en minimisant considérablement la captation de données personnelles. Objets et individus font en effet l'objet d'une représentation schématique, sans possibilité d'identification précise. La Cnil n'en fait cependant pas une technologie miracle, utilisable en toute circonstance. Elle estime que l'usage de caméra Lidar doit être validé au "cas par cas" en tenant compte du contexte de de la finalité recherchée. En outre, la possibilité de croiser un flux Lidar avec un flux vidéo classique fait que ces données ne peuvent être considérées comme totalement anonymes.

Enfin, d'une manière générale, on soulignera que les projets d'IA sont souvent à cheval sur plusieurs réglementations. Les juristes ont dû jongler entre le code des relations entre le public et l'administration (CRPA), le nouveau règlement européen sur l'IA act (entré partiellement en vigueur), le RGPD et des dispositions juridiques spécifiques à la vidéoprotection…. Des considérations qui pourraient inciter les collectivités à temporiser sur les projets d'IA utilisant des données personnelles.