Un guide sur le bon usage des algorithmes administratifs

La loi Lemaire et le RGPD ont énoncé un principe de transparence des algorithmes publics dès lors qu'ils concernent des décisions individuelles. Etatlab vient de publier un guide pour expliciter le champ des algorithmes concernés et les obligations des administrations et collectivités y recourant.

Le calcul du montant d'une aide sociale, l'attribution d'un logement ou d'une place en crèche, la propension d'un quartier à faire l'objet d'actes de délinquance… les algorithmes sont présents depuis plusieurs années dans la sphère publique. Une tendance qui n'est pas près de s'arrêter avec le développement concomitant de l'intelligence artificielle et du big data. Ces formules mathématiques, de plus en plus complexes, suscitent des craintes, comme l'a montré l'affaire de Parcoursup, l'algorithme d'affectation des élèves post bac. Ces formules mathématiques, conçues par des humains, sont en effet sources de biais potentiels, voulus ou non, et sont régulièrement critiquées pour les discriminations qu'elles sont susceptibles de générer.

Calcul automatique ou aide à la décision

À la suite de l'adoption de la loi Lemaire, qui intègre un principe de transparence des algorithmes sur des décisions publiques, lui-même réaffirmé par le RGPD, Etalab a élaboré un guide pour favoriser "un usage responsable des algorithmes publics". Ce document explicite la notion d'algorithme en distinguant ceux qui constituant des outils d'aide à la décision - comme pour l'attribution d'une place en crèche, le résultat de de l'algorithme étant débattu par une commission ad'hoc - des algorithmes qui génèrent des résultats totalement automatisés (par exemple un calcul d'itinéraire, une analyse de risque…).

Quatre critères pour définir un algorithme éthique

La seconde partie détaille les enjeux éthiques et de responsabilité des algorithmes publics, dont la spécificité, par rapport aux algorithmes privés, est d'être utilisés pour des décisions servant l'intérêt général dans le cadre de missions de service public. Le guide rappelle ainsi les quatre critères à respecter pour qu’une décision prise à l’aide d’un algorithme soit considérée comme juste : la transparence (description précise de la procédure), l’intelligibilité (procédure compréhensible par les intéressés), la loyauté (complétude et fidélité de la procédure) et enfin l’égalité de traitement entre des personnes passées à la moulinette de l'algorithme.

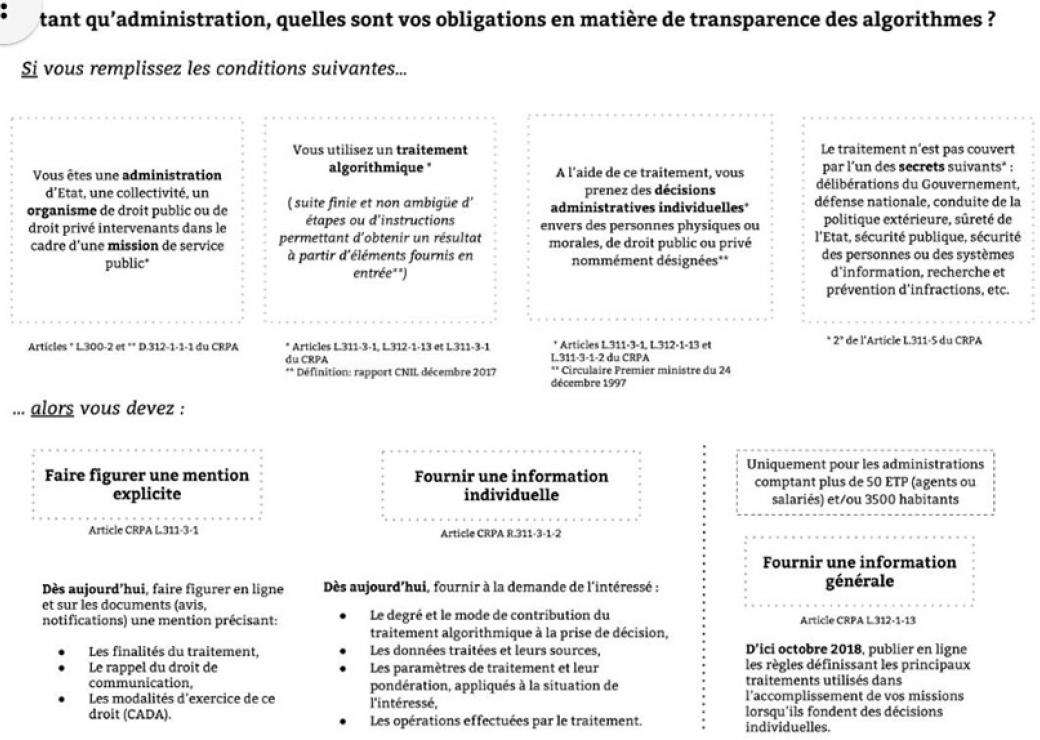

Les obligations à respecter pour les administrations

La troisième partie précise enfin les obligations qui pèsent sur les administrations et collectivités de plus de 3.500 habitants ou plus de 50 agents utilisant des algorithmes. Celles-ci doivent publier en ligne les règles de calculs servant à déterminer des décisions individuelles. Les notifications de décisions individuelles utilisant des algorithmes doivent ensuite explicitement le mentionner. Enfin, l'administration doit être en capacité de fournir à la personne "le degré et le mode de contribution du traitement algorithmique à la prise de décision, les données traitées et leurs sources, les paramètres de traitement et leur pondération, appliqués à la situation de l’intéressé, les opérations effectuées par le traitement". Ce ne sera sans doute pas la partie la plus facile à mettre en œuvre pour une collectivité lambda…

Etatlab précise que la version du guide, publiée sur la plateforme collaborative Github, est ouverte aux commentaires et contributions extérieures.

Quand l'algorithme génère des discriminations raciales

Aux Etats-Unis, la justice utilise le logiciel Compas, établissant "un score de propension à la récidive" par l'analyse de données sur les anciens prévenus. Cet outil a été accusé de racisme par des chercheurs qui ont montré que les scores des afro-américains étaient systématiquement surévalués du fait de la nature des données utilisées. Cet exemple, cité par un rapport de la Cnil montre que les formules mathématiques utilisées peuvent introduire de nouvelles formes de discrimination.